Nvidia forciert zur Computex 2024 den Einsatz von AI in Windows und Spielen, die auch lokal berechnet wird. Entwickler erhalten zu diesem Zweck neue Tools, die ihnen im Zweifel auch die Entscheidung, wo die Modelle berechnet werden, abnehmen. Windows erhält eine neue API, die lokale AI-Berechnungen auf der GPU einfacher macht.

RTX AI PCs vs. Copilot+ PCs

Microsoft, Qualcomm, AMD und Intel – für alle vier Hersteller werden die Copilot+-PCs mit Microsofts KI-Assistenten Copilot+, der eine 40+ TOPS starke NPU voraussetzt, im 2. Halbjahr zum schlagenden Argument im Marketing werden. Nvidia kann da (noch) nicht mitreden, denn ein SoC mit NPU bietet der Konzern bisher nicht an.

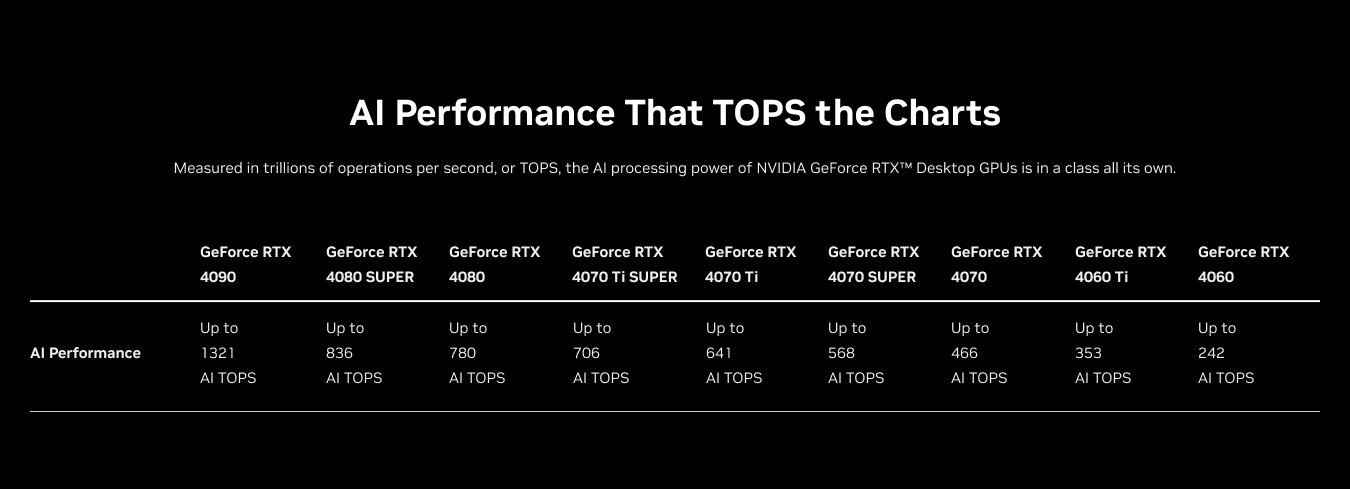

Stattdessen hob CEO Jensen Huang in Taipeh noch einmal die überlegene AI-Leistung der über 100 Millionen PCs weltweit, die über eine GeForce RTX verfügen, hervor: NPUs seien für „leichte“, PC-GPUs für schwere AI-Aufgaben die richtige Plattform.

Eine neue API für lokale AI-Berechnungen auf GPUs in Windows

Um dieses Leistungspotential Entwicklern unter Windows in Zukunft noch einfacher zugänglich zu machen, haben Microsoft und Nvidia zur Computex angekündigt, dass eine neue API später im Jahr als Entwicklervorschau von Windows Einzug halten wird. Sie wird die lokale Berechnung von Small Language Models (SLM) und Retrieval-Augmented Generation (RAG) auf der GPU „out of the box“ ohne weitere Softwareinstallation als Teil der Copilot-Runtime-Umgebung ermöglichen

Microsoft and NVIDIA are collaborating to help developers bring new generative AI capabilities to their Windows native and web apps. Available in developer preview later this year, the collaboration will provide application developers with easy API access to GPU-accelerated SLMs and RAG capabilities that run on-device and are available out of the box as part of Windows Copilot Runtime.

Der Copilot+ bleibt starken NPUs vorbehalten

Was auf den ersten Blick danach klingen mag, dass der Copilot+ in Zukunft auch auf GPUs laufen wird, steckt nicht hinter dieser Ankündigung. Copilot+ setzt auch in Zukunft auf eine NPU mit 40+ TOPS Leistung – diese Einschätzung der Redaktion hat auch Nvidia auf Nachfrage noch einmal bestätigt.

RTX AI Toolkit und AIM SDK

Neue Tools von Nvidia, die es Entwicklern leichter machen sollen, AI in ihre Anwendungen einzubinden, sind das RTX AI Toolkit und das Nvidia AI Inferencing Manager SDK (AIM). Mit dem RTX AI Toolkit sollen sich AI-Modelle einfacher auf die konkreten Bedürfnisse zuschneiden und auf die in PCs vorhandene (GeForce-)Hardware hin optimieren lassen.

Bis dato setzen Entwickler vorrangig auf General-Purpose-Modelle, die für den geplanten Einsatzzweck viel zu komplex ausfallen und viel zu viel Rechenleistung benötigen.

Mit dem RTX AI Toolkit sollen Entwickler kleinere Modelle, die dann auch lokal und damit mit geringerer Latenz und vorallem offline berechnet werden können, entwerfen können. Sie sollen auf allen GPUs lauffähig sein, die beste Leistung sei aber mit GeForce RTX mit Tensor-Cores zu erwarten.

Die lokale Berechnung der AI-Modelle ist dabei nicht zwangsläufig gesetzt. Das neue Nvidia AI Inference Management SDK erlaubt es zu prüfen, was das System zu leisten im Stande ist und bei zu wenig Rechenleistung den Weg in die Cloud zu nehmen – ohne dass der Hersteller sich darüber im Vorfeld selber Gedanken macht.

Nvidia ACE goes local

Die von Nvidia vor einem Jahr angekündigte Avatar Cloud Engine (ACE), die es Entwicklern ermöglicht, KI-Charaktere in Spielen einzubauen, mit denen der Spieler in Echtzeit reden kann, ist eine Plattform, die von AIM direkt profitieren können wird: Ist der PC stark genug, soll sich ACE (anders als der vor einem Jahr erkorene Name erahnen lässt) auch lokal berechnen lassen, andernfalls geht es in die Cloud. Für Entwickler stellt Nvidia derweil neue Online-Services für die Arbeiten mit ACE bereit (NIM).

Remix wird Open Source

Ein weiterer Baustein in Nvidias AI-Gaming-Roadmap bleibt das Tool RTX Remix. Mit ihm lassen sich Rasterizer-Games mit AI-Unterstützung in einer Pathtracing-Variante für GeForce-RTX-Grafikkarten (auch Radeon geht, aber Pathtracing ist und bleibt eine Nvidia-Domäne) umsetzen. Über 100 Spiele werden inzwischen mit Remix überarbeitet, auch Portal RTX (Test) wurde mit Remix umgesetzt.

Zur Computex 2024 hat Nvidia jetzt angekündigt, dass Remix in Zukunft Open Source sein wird: Das umfasst das Toolkit als solches sowie das Remix Runtime SDK. Die Veröffentlichung ist für Juni geplant.

DaVinci Resolve und VLC erhalten RTX Video

Abschließend hat Nvidia angekündigt, dass DaVinci Resolve und der VLC-Mediaplayer RTX Video erhalten werden, mit dem sich Videos hochskalieren und SDR- in HDR-Videos in Echtzeit umwandeln lassen.

ComputerBase hat Informationen zu diesem Artikel von Nvidia unter NDA erhalten. Die einzige Vorgabe war der frühestmögliche Veröffentlichungszeitpunkt.

Artikel von & Weiterlesen ( RTX AI Toolkit, AIM und Remix: Nvidia forciert AI in Spielen, die auch lokal berechnet wird - ComputerBase )https://ift.tt/FrkyXvc

Wissenschaft & Technik

Bagikan Berita Ini

0 Response to "RTX AI Toolkit, AIM und Remix: Nvidia forciert AI in Spielen, die auch lokal berechnet wird - ComputerBase"

Post a Comment